最佳答案了解Robots协议,保护网站信息安全Robots协议,也称为Robots.txt文件,是搜索引擎目录蜘蛛爬行遵循的规则性文件,用于规定搜索引擎蜘蛛哪些页面可以爬取,哪些页面不能够爬取,并规定爬...

了解Robots协议,保护网站信息安全

Robots协议,也称为Robots.txt文件,是搜索引擎目录蜘蛛爬行遵循的规则性文件,用于规定搜索引擎蜘蛛哪些页面可以爬取,哪些页面不能够爬取,并规定爬取页面时需要注意的细节。Robots协议对于一个网站的管理非常重要,下面将详细介绍Robots协议的相关内容。

Robots协议的意义

Robots协议的作用在于指导蜘蛛搜索引擎的爬取行为。搜索引擎蜘蛛可以更快捷高效地收录网站内容,以便于网站能够获取更加精准的流量,提高了网站SEO。

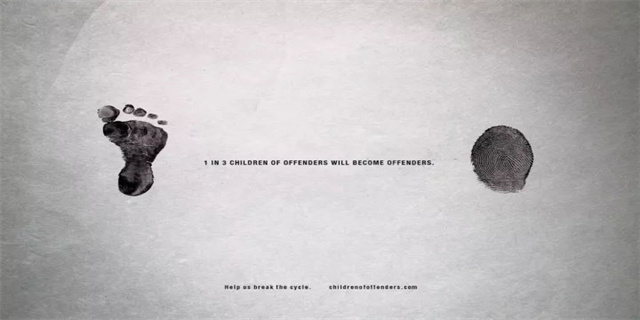

Robots协议内置在网站中,可以通过该协议规定那些页面和文件搜索引擎蜘蛛可以访问,那些页面和文件不允许访问,以此来保护网站信息确保网站信息安全。

Robots协议的编写

Robots协议是一个文本文件,一般在网站的根目录下,该文件不区分大小写。Robots协议的编写方法非常简单,任何人可以使用文本编辑器创建,保存格式为.txt,并将文件名设定为robots.txt,然后上传至网站根目录即可。更加方便的方式是使用Robots协议生成工具来自动生成。

Robots协议应具有以下内容:

User-agent:指定了搜索引擎蜘蛛,可以说明该规则适用的搜索引擎蜘蛛的类别,也可以指定为“*”,表示适用于所有搜索引擎蜘蛛。

Disallow:该命令指定了禁止搜索引擎访问的目录或页面,也可以指定为“/”,表示禁止搜索引擎访问所有文件夹和页面,需要注意的是在Disallow加上一个*的时候,意为的是禁止搜索引擎访问网站下所有的文件和目录。

如果您想让搜索引擎索引整个网站,则只需在Robots文件中留空即可,不用写任何规则。

Robots协议的实用技巧

了解了Robots协议的意义和编写方法后,我们可以通过一些实用的技巧来更好地应用Robots协议:

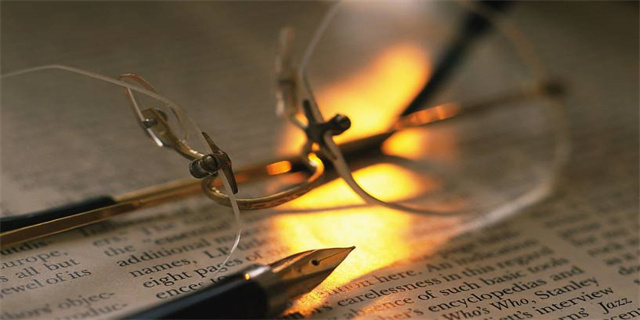

1.禁止引擎爬虫访问敏感目录

禁止搜索引擎蜘蛛访问某些敏感目录是非常必要的,具体方法是在Robots协议中加入Disallow/admin/backup等关键词,因为敏感资料可能包含用户个人信息等重要数据,所以我们必须要对搜索引擎的访问加以限制。

2.排除无关页面与文件

Robots协议不仅可以限制搜索引擎爬虫的访问,同时还可以排除网站中的无关页面。例如某些页面可能已被删除或者已经过时,但是依然被搜索引擎收录,为了保持网站信息的准确性,我们可以通过编写Robots协议来排除无关页面与文件。

3.部分文件允许访问

Robots协议中的Disallow指令不能完全覆盖网站文件,我们可以用allow命令来允许搜索引擎蜘蛛获取指定页面。例如,我们可以让搜索引擎蜘蛛访问某些页面和目录以提高网站排名。

结语

Robots协议是维护搜索引擎和网站之间平衡的重要规则,在网站管理中具有重要的地位。了解Robots协议的意义和编写方法,有效地使用Robots协议可以防止黑客入侵、保护网站信息安全,提高网站的SEO等多方面的作用。

编写Robots协议需要具备一定的技术能力,但是这并非难以掌握,读者可以参照本文中的介绍,了解Robots协议相关内容并应用到实际操作中,从而达到更加有效的网站管理目的。